Activer le mode zen

Ressource au format PDF

Classification

Audition humaine

01/09/2005

Résumé

Le mécanisme de l'audition est un peu moins connu généralement que celui de la vision. Dans cet article, nous allons essayer d'en brosser un tableau concis, en mettant l'accent sur les analogies et les différences avec le fonctionnement de la vision. Nous abordons la question de la localisation des sons, de la perception des fréquences, de la surdité, ainsi que des appareils auditifs.

Table des matières

Nous avons comparé le son et la lumière dans notre article « Rayons sonores et ondes de lumière ? ».

Toutefois, il est impossible de mettre en parallèle le son et la lumière sans se préoccuper, non seulement de la nature physique de ces deux types d'ondes, mais aussi du fonctionnement des organes qui nous permettent de les percevoir. L'étude de l'oeil et de ses défauts a été faite dans l'article « Les défauts de la vision » et quelques expériences simples proposées dans l'article « Quelques expériences simples pour mettre en évidence les propriétés de l'oeil » qui reprenait en partie une série d'expériences proposées par Alfred Cortel.

Le propos de cet article est de constituer le pendant de ces articles sur le fonctionnement de l'oeil, en proposant un résumé succint du fonctionnement de l'ouïe.

Anatomie et fonctionnement de l'oreille

Anatomie de l'oreille

Un bref rappel de quelques éléments constitutifs de l'anatomie de l'oreille nous permettra de mieux comprendre son fonctionnement.

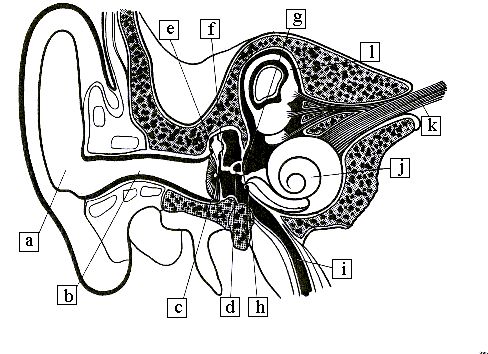

Figure 1. Dessin de l'anatomie de l'oreille

L'oreille externe est constituée du pavillon (a) et du conduit auditif (b). L'oreille moyenne comprend le tympan (c), les osselets : le marteau (e), l'enclume (f) et l'étrier (d), ainsi que la fenêtre ovale (g) et la fenêtre ronde (h).

L'oreille moyenne communique avec les fosses nasales via la trompe d'Eustache (i).

L'oreille interne, enfin, contient la cochlée (j) ainsi que les canaux semi-circulaires (l).

Le nerf auditif (k) transmet l'information sonore au cerveau.

Nous ne parlerons pas beaucoup des canaux semi-circulaires ici, car ils servent à l'équilibration, et nous nous intéressons à l'audition humaine.

Fonctionnement

Les ondes sonores arrivent sur le tympan qu'elles font vibrer. Ces vibrations sont transmises via les osselets à la fenêtre ovale. Après la fenêtre ovale, les ondes sont transmises à l'endolymphe et à la membrane basillaire sur laquelle se trouvent des cellules ciliées. Ce sont des cellules sensorielles (il y a des cellules externes et des cellules internes correspondant au total à environ 35000 fibres nerveuses) qui ont des courbes de sensibilité différentes aux différentes fréquences : les cellules les plus proches de la base de la cochlée ont un pic de sensibilité pour les sons les plus aigus, tandis que les cellules les plus proches de son extrémité ont un pic de sensibilité pour les sons les plus graves.

Les osselets ne transmettent pas seulement les vibrations à l'oreille interne, ils ont aussi un rôle d'adaptation d'impédance.

Les sons perçus par l'oreille humaine varient entre 20 Hz et 20 kHz environ.

Oeil et oreille : une comparaison

L'oreille fonctionne-t-elle de manière analogue à l'oeil? Quelles sont les différences majeures entre ces deux organes?

Nous allons souligner ici seulement deux différences majeures entre l'oeil et l'oreille : la perception des fréquences et la localisation spatiale.

La perception des fréquences

L'oeil, pour percevoir les couleurs (c'est-à-dire les fréquences des ondes qui lui parviennent) dispose de cellules spécifiques à la vision colorée : les cônes. Ceux-ci sont de trois sortes (pour en savoir plus, voir la fiche sur la trivariance visuelle qui donne un aperçu rapide de la question). De ce fait, l'information sur le spectre d'une lumière polychromatique va être traduite par les cônes par trois paramètres seulement. C'est pour cela que deux lumières différentes (c'est-à-dire de spectres différents) peuvent nous sembler avoir la même couleur, si l'impression qu'elles font sur les cônes est identique. Nous percevons l'essentiel des lumières polychromatiques comme des lumières monochromatique d'une certaine fréquence, d'intensité variable, et plus ou moins "lavées de blanc".

Les lois d'addition des couleurs sont l'illustration de ces limitations de l'oeil : la somme de deux lumières de couleurs différentes est perçue comme une troisième couleur : on n'arrive pas à percevoir les fréquences composant le mélange, mais seulement une fréquence dont l'effet est équivalent pour nos yeux.

A contrario, l'oreille dispose de milliers de cellules ciliées de sensibilités différentes. Ces nombreuses cellules permettent une bien plus grande discrimination en fréquence que les trois sortes de cônes de l'oeil.

Ainsi, l'oreille ne perçoit pas seulement une "résultante" de l'ensemble des fréquences composant un son mais est capable d'entendre le spectre d'un mélange de plusieurs fréquences sonores. On est ainsi capable de distinguer un son "pur" (composé d'une seule fréquence) d'un son composé de nombreuses fréquences. C'est ainsi que nous reconnaissons des instruments différentes jouant la même note à leur timbre (qui correspond à la richesse spectrale du son émis par l'instrument) ou que nous savons distinguer un accord d'une note isolée.

Les orchestres n'auraient plus grand sens si un mélange de notes était perçu comme une note unique, de la même façon qu'un mélange de couleurs différentes est perçu comme une unique couleur résultant de l'"addition" de ces couleurs.

L'oreille sait faire la différence entre un orchestre, un instrument isolé, ou une fréquence unique (produite par exemple de façon synthétique) même lorsque la note jouée dans les trois cas est la même. Contrairement à l'oeil qui ne voit qu'une "résultante" du spectre des fréquences qui lui arrive (la couleur), l'oreille sait donc faire la différence entre divers mélanges de fréquences sonores, ainsi qu'entre un son composé de plusieurs fréquences et un son "pur".

Figure 2. Mélange sonores

Figure 3. Mélange de fréquences

Si l'oreille semble supérieure à l'oeil lorsqu'on considère son aptitude à discerner des fréquences différentes, elle lui est par contre très inférieure en ce qui concerne la perception de l'espace.

Localisation spatiale : l'oeil beaucoup plus performant

L'oeil* possède une lentille, le cristallin, qui permet de faire l'image de ce qui est regardé sur la rétine. Si celle-ci ne possède que quatre types de capteurs (en comptant les bâtonnets et les trois types de cônes), elle en possède, par contre, un très grand nombre, disposés sur toute la surface de la rétine et permettant d'obtenir une information spatiale sur les sources lumineuses.

Pour en savoir plus sur l'oeil, voir les articles « Les défauts de l'oeil » et sa version plus orientée vers la biologie sur le site « Vie » sur le fonctionnement de l'oeil et ses handicaps, ainsi que les expériences dans l'article « Quelques expériences simples pour déterminer les propriétés de l'oeil ».

Ainsi, on peut apprécier un paysage, une peinture, etc... L'oeil peut discriminer des détails correspondant à un angle de 1' ou 3 × 10-4 rad, c'est-à-dire qu'il est capable de discerner un déplacement de 1 mm environ à 4 m ou 1 cm à 40 mètres!

L'oreille, bien qu'elle possède un pavillon, ne possède pas de lentille à proprement parler, et ne possède pas non plus de capteurs détectant, comme les capteurs de la rétine, l'origine spatiale du son entendu. Une oreille unique semble donc a priori "aveugle" en soi à la position dans l'espace (on verra un peu plus loin comment nuancer cette position et comment la présence de deux oreilles aide à la perception du relief sonore, bien que cette perception reste très inférieure aux performances obtenues avec nos yeux) tandis qu'elle est très bonne à dissocier les fréquences. De son côté, l'oeil est très efficace en terme de détection spatiale (deux yeux permettant en outre une détection en trois dimensions) et plutôt peu efficace en terme de détection des fréquences, la vision des couleurs ne permettant pas de percevoir toute la richesse spectrale d'une lumière.

Si l'oreille possédait une résolution spatiale identique à celle de l'oeil, alors on pourrait faire des "peintures sonores", dans lesquelles la disposition spatiale des instruments serait d'une précision extrême (le compositeur ferait attention à la position des instruments à 5 centimètres près!). En effet, on peut encore bien distinguer une photo de visage à 1,5 mètre, et si les positions du nez et de la bouche, par exemple, étaient inversées, ça se verrait aussitôt! En prenant une distance de 5 mm entre le nez et la bouche sur la photo, ceci correspond à un angle de 2 × 10-2 rad. Cet exemple illustre les capacités de résolution de l'oeil. L'équivalent, en terme sonore, de ce déplacement du nez dans la photo dont nous venons de parler, correspondrait à un déplacement de 5 cm d'un instrument de musique lors d'un concert, pour un observateur moyen placé à 15 mètres du musicien. Ainsi, ce déplacement de 5 centimètres devrait nous être tout aussi évident, tout aussi choquant, le cas échéant, que l'échange des positions de la bouche et du nez sur un portrait, si l'oreille était aussi performante que l'oeil en terme de résolution spatiale!

Si, de façon similaire, on imagine un oeil aussi apte à discriminer les fréquences que l'oreille, on pourrait faire des "concerts de lampes" dans lesquels on apprécierait l'harmonie spectrale constituée, par exemple, par l'association d'une lampe à incadescence d'amplitude variable avec en contrepoint une lampe à hélium basse pression! Le "timbre" de différentes lampes serait différent : loin d'être restreinte à la perception d'une couleur "résultante", notre vision nous permettrait de ressentir toute la richesse du spectre lumineux de différentes sources.

Distinguer les irisations des bulles de savon n'est possible que parce que l'oeil a une très grande résolution spatiale, bien supérieure à celle de l'ouie et reconnaître une personne à son timbre de voix n'est possible que parce que la perception des fréquences par l'ouie est bien supérieure à celle de l'oeil...

Figure 4. Irisations des bulles de savon

La perception du relief sonore

En dépit de l'absence, au sein de l'oreille, d'un équivalent de ce que représente la rétine pour l'oeil en terme de détection spatiale, on arrive à percevoir avec une certaine précision l'origine des sources sonores. Comment se fait cette localisation sonore?

En premier lieu, tout comme la présence de deux yeux permet d'ajouter le relief, donc une troisième dimension, à la vision bidimensionelle fournie par un oeil unique, la présence de deux oreilles permet une première estimation de l'origine du son. En effet, les sons n'arrivent pas aux deux oreilles en même temps, et cette différence est suffisamment élevée pour être perceptible (la vitesse du son est bien entendu bien plus faible que celle de la lumière). La distance entre les deux oreilles est d'une vingtaine de centimètres et l'intervalle de temps séparant l'arrivée du son aux deux oreilles peut ainsi atteindre 0,6 ms environ.

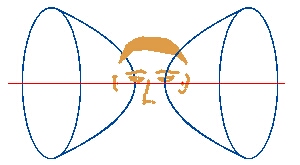

La donnée de l'intervalle de temps séparant l'arrivée du son à chacune des deux oreilles (aussi appelé intervalle de temps interaural) permet de restreindre l'origine possible du son à un hyperboloïde de révolution (en bleu) dont l'axe (en rouge sur le dessin) est la droite reliant les deux oreilles.

Les oreilles permettent donc de localiser un son sur la surface telle que la différence de trajet entre un point de cette surface et chacune des deux oreilles soit constant. Mathématiquement parlant, cette relation définit un hyperboloïde. En fait, le cerveau possède une information additionnelle : l'oreille à laquelle le son est arrivé en premier, la source du son est donc restreinte à un demi-hyperboloïde. Lorsque la source du son est suffisamment loin des oreilles, ce demi-hyperboloïde peut être assimilé à un cône de sommet la tête et dont l'axe est la droite joignant les deux oreilles. Ainsi, la différence de temps interaural permet de déterminer l'angle que fait la source sonore avec l'axe des oreilles.

Deux autres éléments complètent la perception de la différence de temps interaural (ou y suppléent, lorsque l'information donnée par cette différence est trop peu précise) : l'atténuation, surtout pour les fréquences élevées, du son lorsqu'il arrive à l'oreille la plus éloignée de la source par rapport à son intensité au niveau de l'oreille la plus proche (pour les fréquences les plus basses, la diffraction* du son autour de la tête réduit cette atténuation), ainsi que le déphasage de l'onde entre les deux oreilles. Ces trois informations (différence de temps interaural, déphasage et atténuation) contribuent à identifier l'angle que fait la source sonore avec l'axe des oreilles.

les effets de diffraction se font sentir pour des longueurs de l'ordre de la longueur d'onde, ou plus petites. La longeur d'onde λ d'une onde sonore est λ = c / ν où ν est la fréquence de l'onde soit, pour des fréquences audibles comprises entre 20 Hz et 20 kHz, 1,7 cm < λ < 17 m... Le diamètre de la tête étant d'une vingtaine de centimètres, on comprend que les effets de diffractions ne soient pas négligeables, surtout pour les basses fréquences...

Les animaux ont souvent des oreilles aux pavillons mobiles. Si l'homme ne peut en faire autant, il peut incliner la tête dans la direction d'où vient un son : ce mouvement permet de faire une deuxième estimation de l'origine du son, et ainsi d'affiner la perception. On peut alors déterminer plus précisément la direction d'où provient le son mais cette détermination ne permet pas encore, cependant, de savoir exactement la distance à laquelle se trouve la source sonore.

Pour une localisation spatiale plus fine d'un son, d'autres facteurs encore interviennent. Bien entendu, la reconnaissance d'un son habituel permet de préciser en partie sa localisation spatiale (la force d'un moteur de voiture donne ainsi des indications quant à sa distance). D'autre part, l'audition humaine fait intervenir des phénomènes assez complexes : ainsi, les fréquences sont déformées différemment par le pavillon des oreilles suivant leur direction, l'audition fait intervenir non seulement les deux oreilles mais aussi la conduction osseuse, etc. autant d'éléments qui peuvent contribuer, de manière complexe, à la localisation des sons.

De fait, l'oreille humaine moyenne (mais là encore, il y a des variations, selon les individus et leur degré d'entrainement), réussit à localiser l'origine des sons avec une précision satisfaisante, mais qui est loin d'égaler celle de l'oeil. En fait, la meilleure résolution que l'on arrive à obtenir est de l'ordre d'une dizaine de degrés, soit 0,2 rad environ, à comparer avec la résolution de 3 × 10-4 rad que l'on obtient avec l'oeil... L'oeil est au moins 600 fois plus performant dans ce domaine!

Les problèmes d'audition

Différents handicaps auditifs

Les handicaps auditifs peuvent provenir d'un dysfonctionnement des différents éléments contribuant à l'audition.

On distingue :

- Les surdités de transmission, touchant l'oreille externe ou l'oreille moyenne, qui empêchent le son d'être transmis à l'oreille interne

- Les surdités de perception qui touchent l'oreille interne, la cochlée ou le nerf auditif

- Les surdités centrales, enfin, qui correspondent à des lésions des centres nerveux de l'audition dans le cerveau

Les origines de ces surdités sont variables : bouchons de cérumen (il s'agit alors de quelque chose de tout à fait bénin), lésions du tympan (suite à une otite, par exemple), atteinte des osselets (via une ostonspongiose), effet de l'âge (presbyacousie), du bruit...

Un audiogramme permet de préciser la perte auditive en fonction des fréquences. Les surdités dues à l'âge touchent surtout les hautes fréquences, celles-ci étant perçues par les cellules ciliées les plus externes qui sont les premières touchées. Les surdités dues au bruit, au contraire, touchent surtout les fréquences situées entre 3 et 4 kHz.

Ainsi, une personne malentendante souffrant de presbyacousie peut très bien entendre la voix de son interlocuteur mais ne plus comprendre car les fréquences aigues ne sont plus perceptibles alors qu'elle entend encore bien dans les graves.

Les appareils auditifs

L'appareil auditif le plus simple aurait simplement une fonction d'amplification des sons :

- le cornet acoustique ancien

- ou un appareil plus récent comportant un microphone, un amplificateur et un écouteur

réaliseraient tous deux cette forme primitive d'appareil auditif.

Si l'énergie acoustique arrivant à l'entrée du cornet se retrouve intégralement à la sortie, l'intensité du son est multipliée, entre l'entrée et la sortie, par le rapport des surfaces des deux extrémités du cornet. Ceci correspond à une amplification de 20 dB environ pour un cornet traditionnel dans lequel le rapport des rayons aux deux extrémités du cornet serait de l'ordre de 10 (le gain en décibels est donné par la formule : gain(dB) = 10 Log(Isortie/Ientrée) = 10 Log(Surfaceentrée/Surfacesortie).

Figure 6. Schéma d'un cornet acoustique

Toutefois, on s'efforce d'adapter les appareils auditif aux caractéristiques de la déficience auditive dont souffre le malentendant. Amplifier de façon identique toutes les fréquences, lorsqu'il s'agit de se faire entendre d'une personne souffrant de presbyacousie, reviendrait à amener les sons graves (pour lesquels la perte auditive est mineure) à un niveau insupportable à l'oreille, ou à diminuer l'amplification à un niveau supportable, risquant ainsi de rendre les sons aigus inaudibles...

Pour remédier à cet état de fait, les appareils auditifs sont pourvus de filtres qui amplifient différemment les diverses fréquences sonores arrivant à l'oreille.

Conclusion

Les caractéristiques particulières de l'oreille contribuent à une perception de l'univers sonore différente de ce que nous apporte la vue : plus de richesse en fréquences, nous l'avons vu, mais une localisation spatiale bien inférieure. Nous nous sommes efforcés d'aborder les questions essentielles en relation avec l'ouie sous l'angle d'une comparaison entre la vision et l'audition. Il n'en reste pas moins que bien des points n'ont pu être évoqués : stéréophonie, "illusions sonores" qui pourraient faire l'objet d'autres articles...

Pour citer cet article :

Audition humaine, Gabrielle Bonnet, Gilles Camus, septembre 2005. CultureSciences Physique - ISSN 2554-876X, https://culturesciencesphysique.ens-lyon.fr/ressource/Audition.xml